Le 16 SEPTEMBRE 2024

Encadrez la Shadow IA pour profiter de l’IA générative en entreprise

L’utilisation d’outils d’intelligence artificielle tiers facilement accessibles en ligne gratuitement (ou contre quelques dollars par mois) se généralise au fur et à mesure que les outils d’IA générative se démocratisent. Aujourd’hui, les dernières versions de ChatGPT sont accessibles gratuitement avec de moins en moins de limites, Claude et Mistral peuvent être utilisés via une interface de chat assez facilement, la simplicité d’accès et d’utilisation à ces modèles d’IA générative renforce le risque d’une utilisation non maîtrisée.

En entreprise, après les problématiques du “Bring Your Own Device” qui complexifie les démarches de sécurisation des accès aux machines et aux serveurs internes, c’est bien l’usage non accompagné de l’IA par les collaborateurs qui semble être un sujet de fond à adresser rapidement pour éviter de sérieuses déconvenues.

Sommaire:

- Qu'est-ce que la Shadow IA ?

- Des risques de sécurité et de compétitivité

- Encourager l’adoption de l’IA générative

- Gouvernance de l’utilisation des IA

- Utiliser des outils d’IA sécurisés

- FAQ

Shadow IA, véritable défi de la transformation des entreprises

L’utilisation d’outils d’intelligence artificielle tiers facilement accessibles en ligne gratuitement (ou contre quelques dollars par mois) se généralise au fur et à mesure que les outils d’IA générative se démocratisent. Aujourd’hui, les dernières versions de ChatGPT sont accessibles gratuitement avec de moins en moins de limites, Claude et Mistral peuvent être utilisés via une interface de chat assez facilement, la simplicité d’accès et d’utilisation à ces modèles d’IA générative renforce le risque d’une utilisation non maîtrisée.

En entreprise, après les problématiques du “Bring Your Own Device” qui complexifie les démarches de sécurisation des accès aux machines et aux serveurs internes, c’est bien l’usage non accompagné de l’IA par les collaborateurs qui semble être un sujet de fond à adresser rapidement pour éviter de sérieuses déconvenues.

En savoir plus : IA générative : créez des chatbots IA de confiance.

Des risques de sécurité et de compétitivité

Les collaborateurs attirés par les capacités surhumaines des modèles d’intelligence artificielle disponibles en quelques clics ne se posent pas beaucoup de questions : si ça peut m’aider, j’essaye. ChatGPT l’a bien compris et sait se rendre indispensable : l’essayer c’est l’adopter. Pour des tâches du quotidien comme la rédaction d’email ou la synthèse de documents cela semble en effet presque magique et sans risque.

Pourtant en utilisant des outils tiers, à fortiori gratuits, chaque requête est envoyée vers l’API de ce fournisseur de service, informations confidentielles comprises. On se souvient par exemple du géant Samsung qui interdisait l’utilisation de ChatGPT à ses équipes suite à des fuites de code source propriétaire vers OpenAI suite à des discussions de ses ingénieurs avec l’IA pour identifier des bugs dans leur code.

La fuite d’informations confidentielles et sensibles (des données personnelles par exemple) est un risque majeur de l’utilisation non encadrée de l’AI générative en entreprise. Les utilisateurs ne se rendent pas toujours compte de l’impact d’un simple message échangé avec un chatbot d’allure joviale et au contact sympathique.

Il existe également une véritable perte de contrôle sur les contenus générés par l’IA, d’autant plus avec l’utilisation de modèles “sur étagères” dont on ne connaît pas vraiment la base d’entraînement et qui sont incapables d’expliquer leur fonctionnement. ChatGPT ou Gemini ne sont pas des moteurs de recherche, ils ne sont pas non plus des moteurs de réponses fiables et irréprochables. Un collaborateur qui pense pouvoir faire confiance à 100% aux réponses de son IA personnelle fait prendre des risques à son entreprise, en plus de se mettre en défaut personnellement.

Imaginez une base de connaissance métier alimentée uniquement par des éléments inventés par des intelligences artificielles, non spécialistes du sujet, sans contrôle humain : comment pouvez-vous ensuite l’utiliser en confiance pour servir vos collaborateurs et vos clients ?

L’ampleur juridique de litiges qui découlent d’une utilisation non encadrée d’IA générative peuvent également s’avérer très complexes à de nombreux niveaux : réglementation sur les données personnelles, respect de l’AI Act, propriété intellectuelle, fuites de données confidentielles, copyright... Les angles d’attaque sont très nombreux et très sensibles pour les entreprises impactées.

Encouragez le changement et l’adoption

L’origine de ce phénomène de Shadow IA est souvent une impulsion positive à saisir pour l’organisation : vos collaborateurs ont bien saisi les opportunités et ont voulu profiter de ce gain de productivité rapidement. Il y a donc un terreau d’innovation et d’efficacité opérationnelle à saisir !

Il ne faut surtout pas interdire par défaut, mais en profiter pour mener une véritable campagne de sensibilisation et de formation des équipes. Pour mettre en place une charte d’usages autorisés et de pratiques interdites, il faut que tout le monde comprenne bien les enjeux et que cela soit discuté et concerté. Ce dialogue permet de se poser, ensemble, les bonnes questions pour faire de l’IA générative un vecteur de transformation et d’amélioration des processus en place pour que chaque collaborateur en tire profit au quotidien.

Mettre en place une gouvernance de l'utilisation des IA génératives

La charte de bonne utilisation de l’IA générative devient indispensable en entreprise, au même titre que la charte télétravail ou la charte informatique. Elle doit répondre à ses sujets essentiels comme :

- quels outils d’IA générative sont autorisés ?

- quels accès doivent être utilisés ?

- quelles données peuvent être fournies à une IA ?

- quelles données sensibles ne peuvent en aucun cas être utilisées pour prompter une IA générative ?

- pour quelles tâches peut-on les utiliser ?

- pour quelles tâches est-ce interdit ?

- comment identifier des contenus générés par IA ?

- qui est responsable des contenus générés par IA ?

L’élaboration de cette charte permet de faire converger des sujets stratégiques de transformation de l’organisation, les problématiques d’éthique et les valeurs de l’entreprise, avec les besoins très opérationnels des équipes. L’adoption de ces règles de gouvernance est primordiale pour se prémunir des risques inhérents à la Shadow IA, et à l’intelligence artificielle de façon plus générale.

Il y a aujourd’hui un très gros effort à mener sur la formation des équipes au sein des entreprises pour pouvoir utiliser plus sereinement l’IA générative et en tirer profit. Cette formation continue doit permettre à chacun de comprendre les risques mais aussi de mieux se saisir des opportunités. Cela va dans le sens des actions du Conseil National du Numérique (CNum) avec les cafés IA destinés au grand public.

Utiliser des outils encadrés et sécurisés

Pour accéder à de l’information dans un cadre professionnel, la sécurisation des données est un sujet sensible. De l’authentification forte des utilisateurs au monitoring des activités de chaque modèle d’IA utilisé en interne, de nombreuses bonnes pratiques sont indispensables pour assurer un usage qui respecte les guidelines de cybersécurité et éviter des attaques vers les systèmes d’information.

Si OpenAI a rapidement proposé des accès business pour onboarder des équipes de plusieurs dizaines ou centaines de collaborateurs, il est légitime de se poser des questions sur l’utilisation qui est faite des données saisies par les utilisateurs.

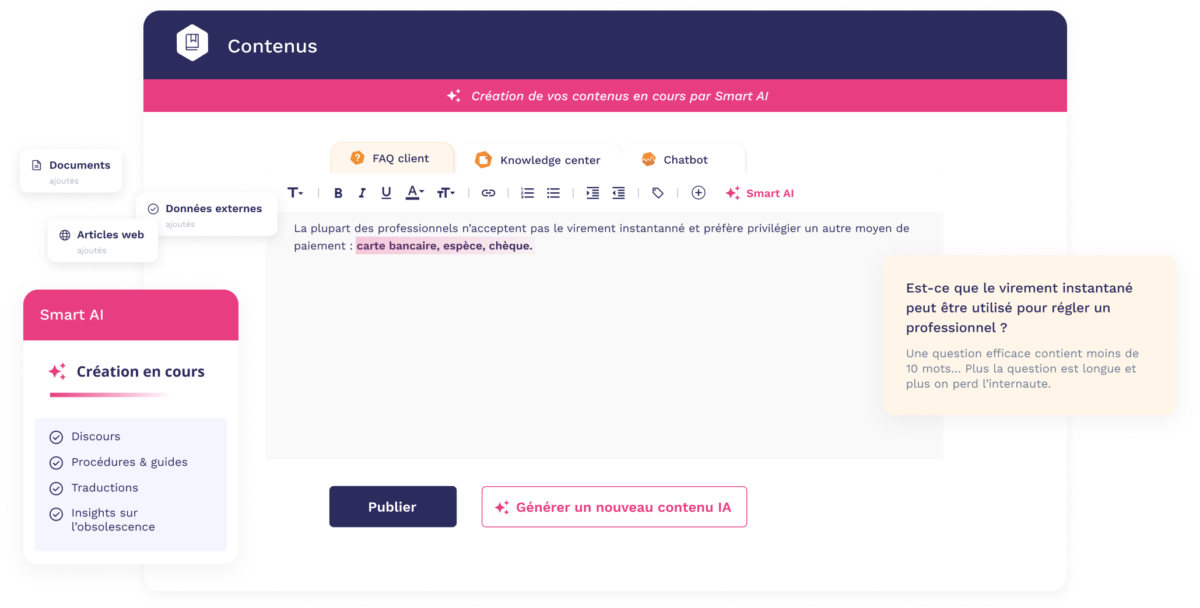

L’utilisation de grands modèles de langage dans des services aussi sensibles et engorgés que le support et le service client, nécessite la création de séquences IA dédiées. Ces séquences sont capables de faire des recherches d’informations précises et de mettre en forme la réponse pour qu’elle colle à la tonalité de la marque. Il ne s’agit pas d’un seul modèle interrogé par un prompt immuable, mais bien d’une suite d’agents IA entraînés spécifiquement pour chaque tâches. Des agents qui sont entraînés précisément pour ces tâches et qui doivent rendre des comptes à tout moment !

Si l’acculturation et la formation facilitent l’usage raisonné et raisonnable des outils d’IA générative par vos équipes, il est nécessaire de mettre en place des outils de monitoring pour apprécier l’activité et l’usage de chacun. Pas dans une optique de flicage, mais plutôt pour bien comprendre les cas d’utilisation et la consommation de chaque collaborateur en ressources IA. Cela peut même vous donner des pistes d’optimisation en faisant remonter des bonnes pratiques au cœur de vos métiers grâce à l’ingéniosité et à l’appropriation des modèles par vos talents.

Accompagnez vos collaborateurs et équipez-vous dès maintenant !

Ajouter une dose d’IA générative dans le quotidien de vos équipes demande de la préparation, de la rigueur et de l’accompagnement. Non, il ne suffit pas d’acheter une licence entreprise de ChatGPT ou Claude pour exploiter correctement les opportunités offertes par l’intelligence artificielle générative. Une connaissance, même très simple, de comment fonctionnent ces algorithmes est indispensable pour bien saisir ce que l’on peut ou ne peut pas déléguer à cette IA générative. Cela permet également de rassurer des équipes qui peuvent souvent lire dans la presse qu’ils seront bientôt remplacés par ces “IA” dont on ne cerne pas toujours bien les forces et les faiblesses.

Dans son étude “AI at Work 2024: Friend and Foe”, le Boston Consulting Group identifie 3 challenges auxquels font face les utilisateurs en entreprise :

- un manque de temps pour apprendre à utiliser l'outil

- une formation inefficace

- des incertitudes des utilisateurs quant au bon moment d'utiliser l’IA générative

De leur côté, les dirigeants et cadres d’entreprise identifiant 3 problématiques assez complémentaires :

- un manque de connaissance de l'IA et de l’IA générative dans les fonctions non techniques

- des incertitudes quant au moment d'utiliser l’IA générative

- un manque de talents spécialistes IA et l’IA générative

L’acculturation et la formation de tous est une condition sine qua non de l’adoption efficace de tous ces outils d’intelligence artificielle générative en entreprise. Le temps du test et de la découverte est passé, il est temps de passer à l’étape suivante pour industrialiser à l’échelle les bénéfices de ces technologies sur des cas d’usage bien précis. Un passage à l’échelle qui doit être encadré, supervisé et encouragé pour en limiter les risques et se concentrer sur les gains de productivité et d’efficacité opérationnelle, tout en assurant une transformation des métiers où chacun trouve sa place.

Se saisir dès aujourd’hui de ces problématiques en mettant en place des outils d’IA générative responsable est incontournable. Chez Smart Tribune nous concevons des produits d’IA qui suivent ces pré-requis pour accompagner les collaborateurs des services de relation client et bien au-delà. Nous ne faisons pas que croire à ces valeurs d’éthique et de confiance, nous travaillons au quotidien en recherche et développement et lors de la conception des projets de nos clients pour y répondre “by design”.

Pour mettre en place des projets d’IA générative de confiance et accélérer l’adoption de vos équipes en confiance et en sécurité, faites appel aux experts Smart Tribune qui seront trè!s heureux d’imaginer le plan d’acculturation et de formation adapté à votre organisation. Évitez les risques de la Shadow IA et faites-en une force !

FAQ

1. Qu'est-ce que la Shadow IA (et pourquoi est-ce un problème pour les entreprises) ?

La Shadow IA représente l’ensemble des utilisations de l’intelligence artificielle par des collaborateurs, sans que l’organisation en soit au courant ou ne puisse en maîtriser les risques. Certaines équipes utilisent sans doute l’intelligence artificielle générative de leur propre initiative, sans forcément en comprendre les risques notamment en termes de compétitivité et de données sensibles. La Shadow IA est un danger si elle n’est pas comprise et accompagnée par les cadres et managers.

2. Comment les entreprises peuvent-elles atténuer les risques associés à l'IA “clandestine” ?

Les entreprises peuvent atténuer les risques associés à cette IA personnelle et clandestine en ouvrant la dialogue avec les collaborateurs pour comprendre leurs usages et capitaliser sur les bonnes pratiques. Atténuer les risques passe par un échange constructif au sein des équipes, afin de profiter de ces usages pour améliorer la productivité tout en encadrant les problématiques liées aux données, à leur confidentialité et aux risques d’hallucinations et donc aux responsabilités.

3. Quels sont les coûts potentiels de l'utilisation non réglementée de l'IA générative dans une entreprise ?

Les coûts associés sont très variés car cette utilisation non encadrée de l’IA générative en entreprise peut prendre plusieurs formes. Fournir des données personnelles de clients à ChatGPT peut tomber sous le coup du RGPD avec des sanctions lourdes. Recopier stricto sensu des clauses juridiques fournies par un LLM peut également entraîner des coûts certains. Enfin, il faut également prendre en compte les problématiques de copyright, notamment pour de la génération d’images.

4. Comment encourager l'adoption en toute sécurité des outils d'IA générative par les employés ?

Pour encourager l’adoption de l’IA générative en entreprise, il faut prendre le temps d’expliquer comment fonctionnent ces outils pour en saisir les opportunités et les limites. Il faut faire preuve de pédagogie pour accompagner ce changement en profondeur de nombreux métiers de l’entreprise. Apportez des conseils et des solutions avant de vouloir bannir complètement l’utilisation de ChatGPT dans vos équipes. Et pour aller plus loin, faites confiance à des acteurs capables de vous proposer des solutions basées sur votre expertise métier et vos propres données.